コンピュータエンターテインメント協会(CESA)は、8月24日~26日の期間、オンラインにて、国内最大のゲーム開発者向けカンファレンス「コンピュータ・エンターテインメント・デベロッパーズ・カンファレンス 2021」(CEDEC 2021)を開催した。

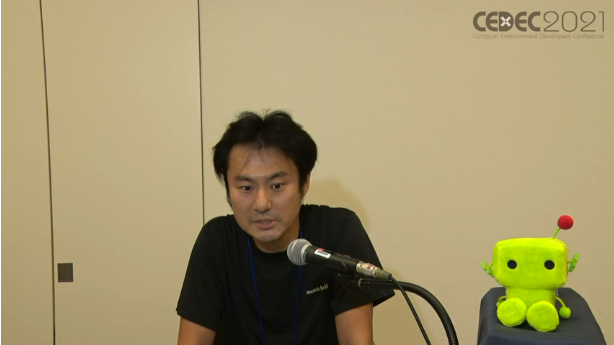

本稿では、8月25日に行われた、ポケラボ・ゲーム事業本部/エンジニアマネージャーの覚張泰幸氏による「SINoALICE -シノアリス- グローバル版 「ワールド統合」の裏側 大公開!!」をレポートしていく。

▲ポケラボ・ゲーム事業本部/エンジニアマネージャーの覚張泰幸氏。『シノアリス』エンジニア統括として立ち上げから参画。現在は同タイトルのグローバル版のエンジニア統括を担当している。

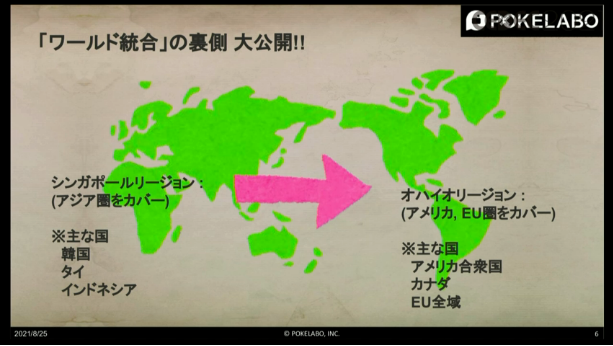

ここで覚張氏は本講演を行うに至った理由として、世の中に出ているゲームの中でワールドが分割されているアプリは珍しくないが、ワールドを統合したアプリは珍しく、この経緯やナレッジをCEDECで公開したいと考えたと説明した。

また、ワールド統合前は全ての構成が分かれていたため、開発者はどちらのワールドでも正しく動作するように作りこまなければならないうえ、メンテナンスに関しても2つのワールドに対して同じ作業を行う必要があった。そういった意味では、開発・運用工数の削減、インフラ費用の削減、利益率の向上など、ユーザーだけでなく開発としてもメリットの大きい試みとなったとのことだ。

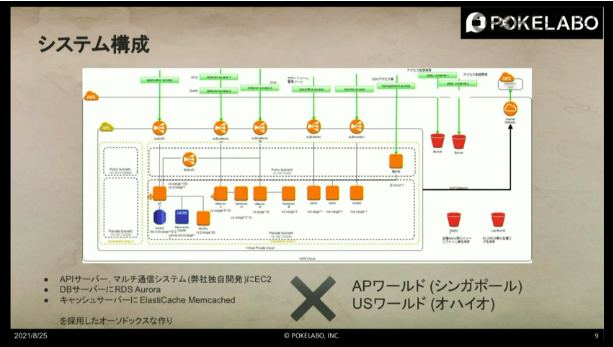

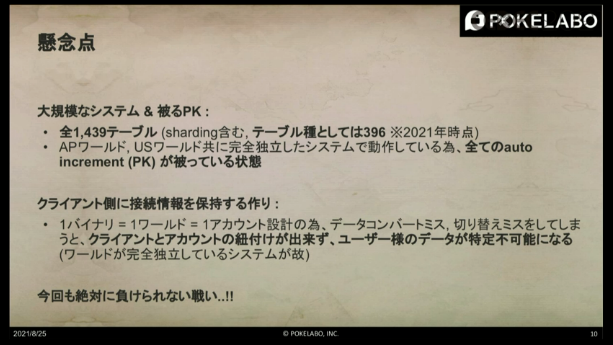

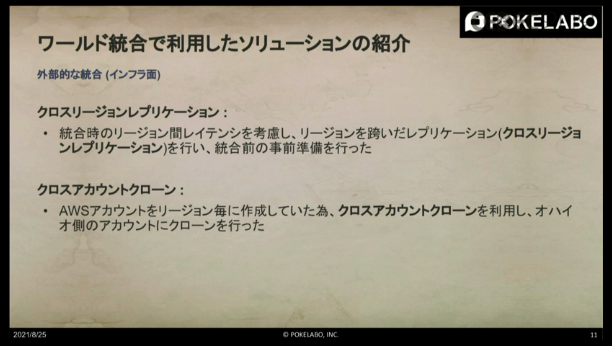

ここからは、ワールド統合に関するより具体的な内容を紹介。

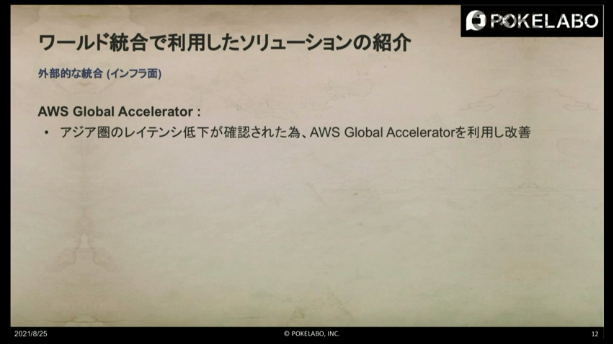

▲なお、「AWS Global Accelerator」を利用した結果、条件に合ったときにデータベースが公表している値以上の効果があり、特に東南アジアの改善が著しかったと感想を述べた。

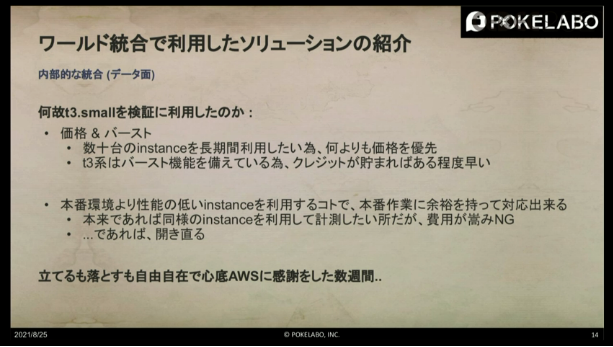

開発環境にt3.smallを採用した理由は、ずばり”価格とバースト”であると覚張氏は述べる。本番で利用しているインスタンスタイプが大きなものであるため、長期間抱えるとインフラコストが莫大なものになってしまう。そこで、安くてコスパが良いt3.smallを選定したと説明した。また、本番環境よりも性能の低いインスタンスを利用することで本番環境でも余裕を持って対応ができるほか、t3.smallはバーストするため、クレジットが残っていればある程度は性能も出るという。

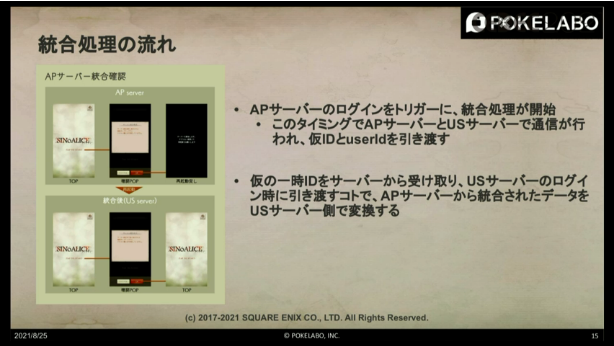

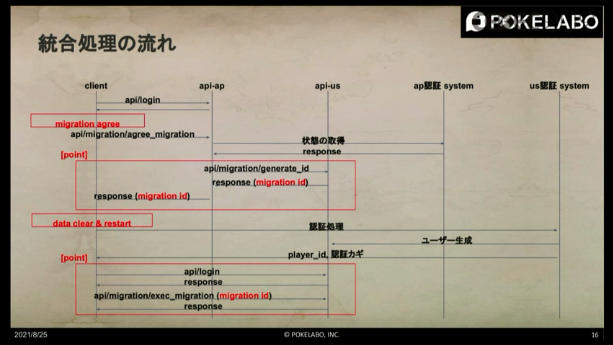

統合同意のタイミングで、APサーバーとUSサーバー間で通信を行っており、そこでmigration idを生成。クライアント側は、このmigration idを保持した状態でリセットをかけ、空の状態に。その後、USサーバーに対してユーザーを新規作成し、USサーバーにログインしたタイミングで先ほど生成したmigration idを引き渡して移行ユーザーであること、APサーバーにてどのユーザーであったかを特定して新規作成されたUSサーバーのユーザーに対して統合されたAPサーバーのユーザー情報を上書きするようなイメージであると覚張氏は説明した。

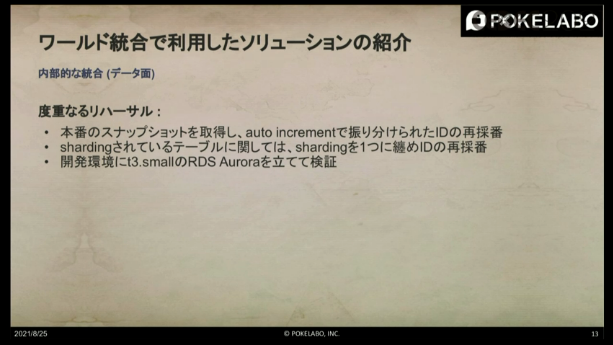

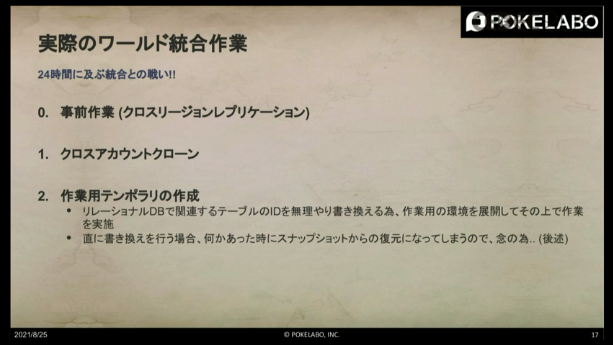

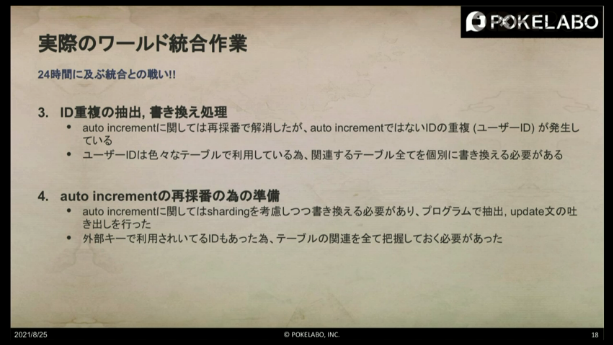

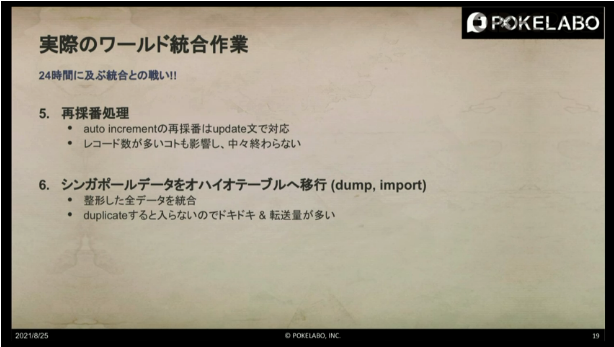

5つ目の工程となる再採番処理は、先ほど4のフェーズで作成した内容を適用していく処理になる。

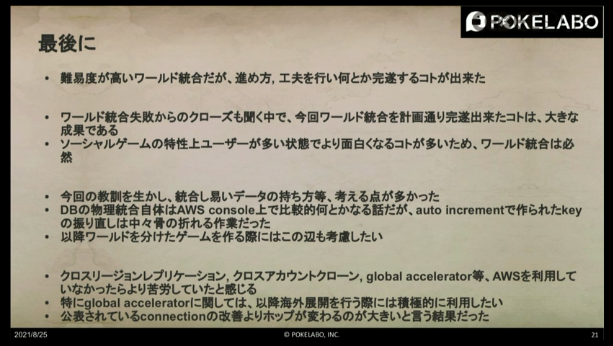

このように、大規模運用タイトルのワールド統合の難易度は想定していたより高かったが、進め方や工夫を行って完遂することができたとまとめた。ワールド統合失敗からのクローズという話もある中、今回、時間通りにワールド統合を完遂できたことは大きな成果であると感じているという。また、ソーシャルゲームの特性上、ユーザーが多い状態の方が面白くなることが多いと考えており、ワールド統合自体は必然であったと述べる。

最後に覚張氏は、この登壇が皆様の糧になれば幸いだとして講演の締めとした。

(取材・文 編集部:山岡広樹)

会社情報

- 会社名

- ポケラボ

- 設立

- 2007年11月